撰文:Andrew Tarantola

来源:Engadget

图片来源:由无界 AI工具生成

Dall-E 和 Stable Diffusion 只是开始。随着人工智能生成系统的普及,以及各公司努力将自己的产品与竞争对手的产品区分开来,互联网上的聊天机器人正在获得编辑和创建图片的能力,Shutterstock 和 Adobe 等公司就是其中的佼佼者。但是,这些新的 AI 功能也带来了我们熟悉的问题,比如未经授权篡改或直接盗用现有的在线作品和图片。水印技术可以帮助减少后者问题,而麻省理工学院 CSAIL 开发的新型“PhotoGuard”技术则可以帮助我们防止前者的出现。

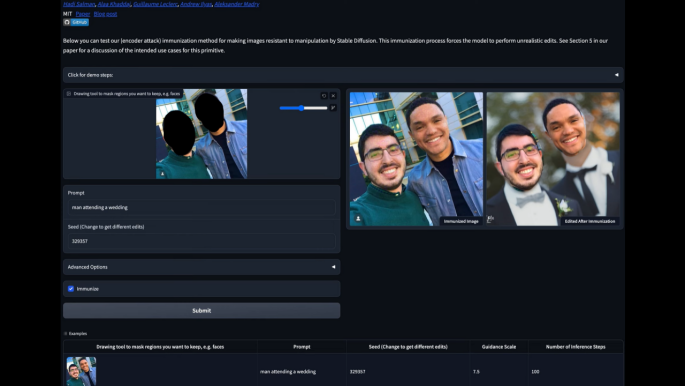

据悉,PhotoGuard 的工作原理是改变图像中的部分像素,从而破坏 AI 理解图像内容的能力。研究团队所说的这些“扰动”,人眼是看不见的,但机器很容易读懂。引入这些伪影的“编码”攻击方法针对的是算法模型对目标图像的潜在表示 -- 描述图像中每个像素的位置和颜色的复杂数学 -- 从根本上阻止了人工智能理解它正在看什么。(注:伪影 (Artifacts) 是指原本被扫描物体并不存在而在图像上却出现的各种形态的影像。)

此外,更先进、计算量更大的“扩散”攻击方法会将图像伪装成人工智能眼中的另一幅图像。它将定义一个目标图像,并优化其图像中的扰动,使其与目标图像相似。人工智能试图对这些“免疫”图像进行的任何编辑都会应用到伪造的“目标”图像上,从而生成看起来不真实的图像。

“编码器攻击会让模型认为(要编辑的)输入图像是其他图像(如灰度图像),”麻省理工学院博士生、论文第一作者 Hadi Salman 告诉 Engadget。“而扩散攻击则迫使扩散模型对一些目标图像(也可以是一些灰色或随机图像)进行编辑。”这种技术并非万无一失,恶意行为者可能会通过添加数字噪音、裁剪或翻转图片等方式,对受保护的图像进行逆向工程。

“涉及模型开发人员、社交媒体平台和政策制定者的协作方法可以有效防御未经授权的图像操纵。解决这一紧迫问题在今天至关重要。”Salman 在一份新闻稿中表示。“虽然我很高兴能够为这一解决方案做出贡献,但要使这一保护措施切实可行,还有很多工作要做。开发这些模型的公司需要投入资金,针对这些 AI 工具可能带来的威胁进行强大的免疫工程设计。”

本文链接:https://www.aixinzhijie.com/article/6827754

转载请注明文章出处